Apesar de estar preso, o ex-primeiro-ministro do Paquistão Imran Khan participou na campanha para as legislativas e celebrou a vitória com um discurso para os apoiantes. Tudo graças à inteligência artificial que recriou a sua voz e colocou-o a proferir uma mensagem composta a partir de notas que Khan passou para o exterior da cadeia. “A clonagem de voz tornou-se uma ferramenta para publicidade política enganosa”, alerta ao Expresso um especialista na área da Computação e da Inteligência Aumentada. “A educação pública relativamente à existência de deepfakes e a necessidade de ser cético sobre o que se vê, lê e ouve é fundamental nesta era de conteúdos gerados por inteligência artificial”

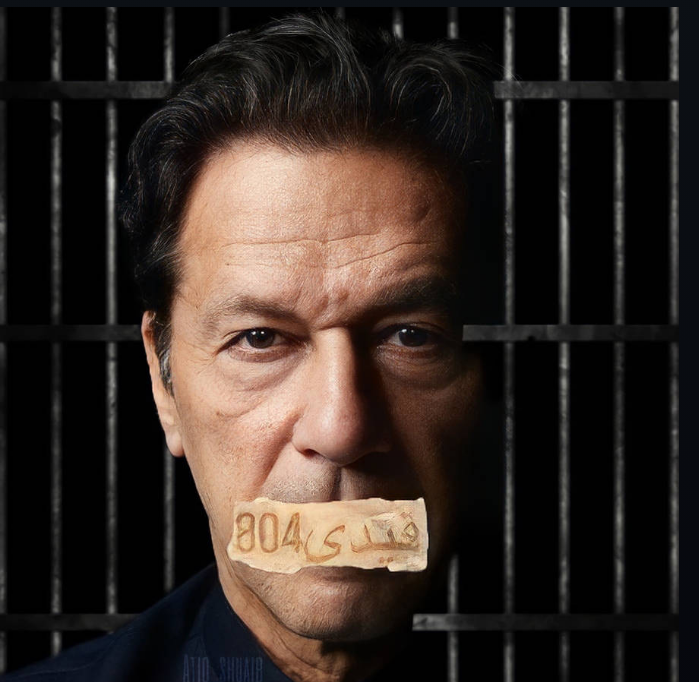

Imran Khan vendeu caro o seu afastamento da política ativa e da vida em liberdade. Detido desde agosto e sujeito a uma catadupa de processos na justiça — orquestrados pelos militares, com motivações políticas e assentes em acusações forjadas, assim pensa ele e quem o defende —, o antigo primeiro-ministro do Paquistão viu os candidatos conotados com o seu partido ganhar a maioria dos assentos no futuro Parlamento, nas eleições de quinta-feira passada.

Com o partido de Khan dissolvido pelo Supremo Tribunal, militantes perseguidos e ele próprio desqualificado para concorrer — só nas últimas duas semanas, recebeu três penas de prisão de 10, 14 e 7 anos, por divulgação de segredos de Estado, corrupção e casamento ilegal, respetivamente —, os candidatos do Pakistan Tehreek-e-Insaf (PTI) apresentaram-se nas urnas como independentes.

Quer os entraves ao funcionamento do partido, quer as restrições adotadas pelas autoridades no dia das eleições — que decretaram um blackout nas comunicações móveis e na Internet durante o período de votação — não foram suficientes para o derrotar. Imran Khan está encarcerado, mas não o está a sua enorme popularidade, que advém dos tempos em que era uma estrela do críquete e capitaneou a seleção paquistanesa na única vez que venceu o Mundial, em 1982.

92

dos 260 deputados eleitos, a 8 de fevereiro, para a Assembleia Nacional são independentes apoiados pelo PTI de Imran Khan. Será a fação maioritária no parlamento

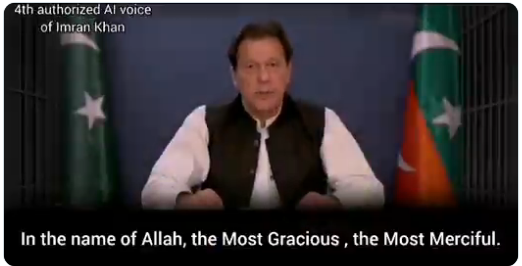

Na hora de celebrar a vitória, foi Imran Khan “quem fez” o discurso para os seus apoiantes — não de viva voz, dado estar preso e privado de participar em atos políticos, mas com o seu timbre vocal gerado por inteligência artificial, numa demonstração de como a tecnologia pode ser usada para contornar a repressão política.

Num vídeo, uma imagem antiga de Khan surge a discursar com os movimentos labiais sincronizados com o som criado pela inteligência artificial. A mensagem foi composta a partir de notas passadas pelo próprio aos seus advogados.

“Eu tinha plena confiança de que todos vocês iriam votar. Todos vocês honraram a minha fé e a vossa participação massiva surpreendeu a todos”, disse a voz de Khan. (Abaixo a versão do discurso em língua inglesa.)

Não foi a primeira vez que o staff de Khan socorreu-se da tecnologia para combater as restrições impostas ao partido e contornar a censura noticiosa às suas iniciativas. Durante a campanha, militantes do PTI alimentaram a dinâmica eleitoral organizando comícios digitais em plataformas como o YouTube e o TikTok, com a voz de Khan gerada por inteligência artificial. Abaixo, outro exemplo.

“A equipa de redes sociais do PTI emergiu como um farol de inovação, empregando técnicas engenhosas para chegar aos cidadãos em todo o país, uma reminiscência de tigres encurralados que lutam pela sobrevivência”, reconheceu o próprio partido. A televisão árabe “Al-Jazeera” rotulou a estratégia da equipa de Imran Khan de “campanha de guerrilha”.

“Esta é, sem dúvida, uma boa utilização da clonagem de voz, dadas as circunstâncias” repressivas em torno da candidatura de Imran Khan, diz ao Expresso Subbarao Kambhampati, professor na Escola de Computação e Inteligência Aumentada, da Universidade Estatal do Arizona (EUA). Porém, “com mais frequência ouvimos e preocupamo-nos com o mau uso ou utilizações perigosas, como a utilização de vozes clonadas em anúncios políticos enganosos.”

Um exemplo recente teve como protagonista o Presidente dos Estados Unidos, Joe Biden. Nas vésperas das primárias democratas no estado do New Hampshire, que se realizaram a 23 de janeiro, uma voz criada para soar como a do candidato democrata foi usada em mensagens telefónicas gravadas destinadas a desencorajar as pessoas de irem votar.

“O seu voto faz diferença em novembro, não nesta terça-feira”, ouvia-se. Para 5 de novembro estão agendadas as eleições presidenciais. “Embora a voz na chamada automática soe como a voz do Presidente Biden, esta mensagem parece ter sido gerada artificialmente”, apurou o gabinete do procurador-geral de New Hampshire.

“A clonagem de voz tornou-se uma ferramenta para publicidade política enganosa”, alerta Subbarao Kambhampati. “Embora as autoridades se esforcem por penalizar estas práticas e por ajudar a detetá-las (por exemplo, colocando marcas de água nos meios de comunicação gerados sinteticamente), estas medidas não serão suficientes para impedir que aqueles que espalham desinformação usufruam dos dividendos das suas mentiras.”

Uma das normas de segurança recentes é o C2PA, desenvolvido por grandes empresas de tecnologia, como a Microsoft e a Adobe. Visa a criação de um protocolo universal de Internet que permita aos criadores de conteúdos adicionarem um “rótulo nutricional”, como lhe chama o prestigiado Instituto de Tecnologia de Massachusetts (MIT), com informações sobre a sua origem: de onde veio e quem ou o quê o criou.

Do além para a campanha

Outro exemplo recente de uma voz clonada para fins políticos, e que parece confirmar a tendência para que 2024 sobressaia como um ano de grande desinformação eleitoral, aconteceu na Indonésia, onde, esta quarta-feira, realizam-se eleições presidenciais.

Suharto, um antigo general que governou o arquipélago indonésio com ‘mão de ferro’ durante mais de 30 anos, e que morreu em 2008, ‘ganhou vida’ num vídeo criado por inteligência artificial que clona a voz e a imagem do antigo ditador.

“O vídeo foi feito para nos lembrar da importância dos nossos votos nas próximas eleições”, disse Erwin Aksa, vice-presidente do Golkar, o partido político que promoveu o vídeo. O Golkar não apresentou um candidato presidencial próprio, mas deu apoio a Prabowo Subianto, o atual ministro da Defesa, que é genro do ditador Suharto.

Para Subbarao Kambhampati, a integração na política das ferramentas deepfake — que usam inteligência artificial para fundir, substituir ou sobrepor áudios e imagens, produzindo assim vídeos e áudios falsos — veio para ficar. “Nos próximos anos, certamente irá difundir-se mais. Depois disso, a nossa capacidade de adaptação à nova realidade — e de não confiarmos em informações que não sejam autenticadas (como, por exemplo, por jornais de confiança, tecnologia de marca de água digital ou tecnologia de autenticação criptográfica) — será alcançada e iremos aceitá-la com calma.”

Segundo o professor, à medida que as falsificações se tornem mais sofisticadas, também aumentará a nossa imunidade a elas: “Aprenderemos a não confiar nos nossos sentidos e a insistir na autenticação”.

Até lá, deixa um conselho: “A educação pública relativamente à existência de deepfakes e a necessidade de ser cético sobre o que se vê, lê e ouve é fundamental nesta era de conteúdos gerados por inteligência artificial”.

Artigo publicado no “Expresso Online”, a 13 de fevereiro de 2024. Pode ser consultado aqui